BellaDati 2.9からビッグデータセットが利用可能です

ビッグデータセットは、非常に大量のデータを保存し、事前に計算されたキューブを構築するために使用できる特別なタイプのデータセットです。標準データセットとビッグデータセットの主な違いは以下の通りです:

- レポートをビッグデータセットに直接作成することはできません。最初にキューブを作成する必要があります。

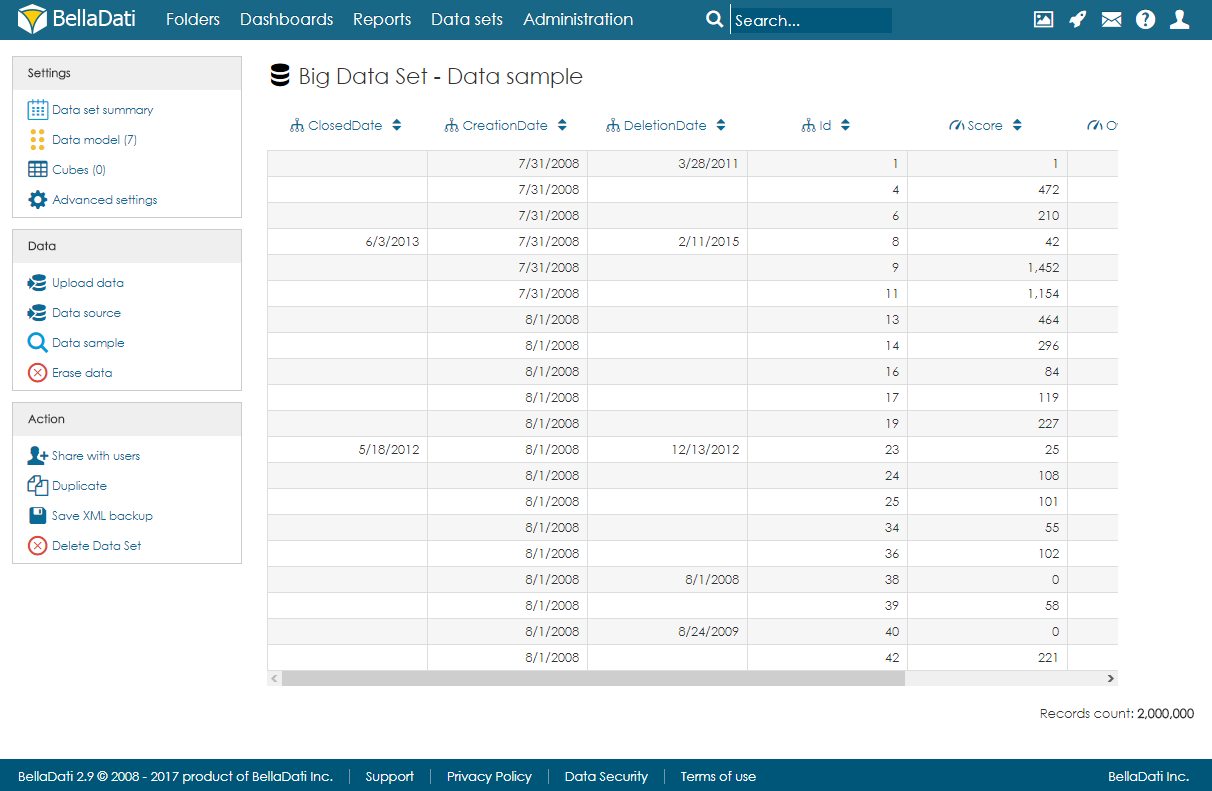

BellaDati 2.9.17以降、レポートはビッグデータセットに直接作成できます。 - ビッグデータセットでは、すべてのデータを閲覧することはできません。ランダムなデータサンプルのみが利用可能です。データサンプルでは、フィルター、編集機能、削除機能は使用できません。

- ビッグデータセットは結合できません。

ビッグデータセットの主な利点は、事前に計算されたキューブを作成できるため、レポートの読み込み時間が高速化されることです。

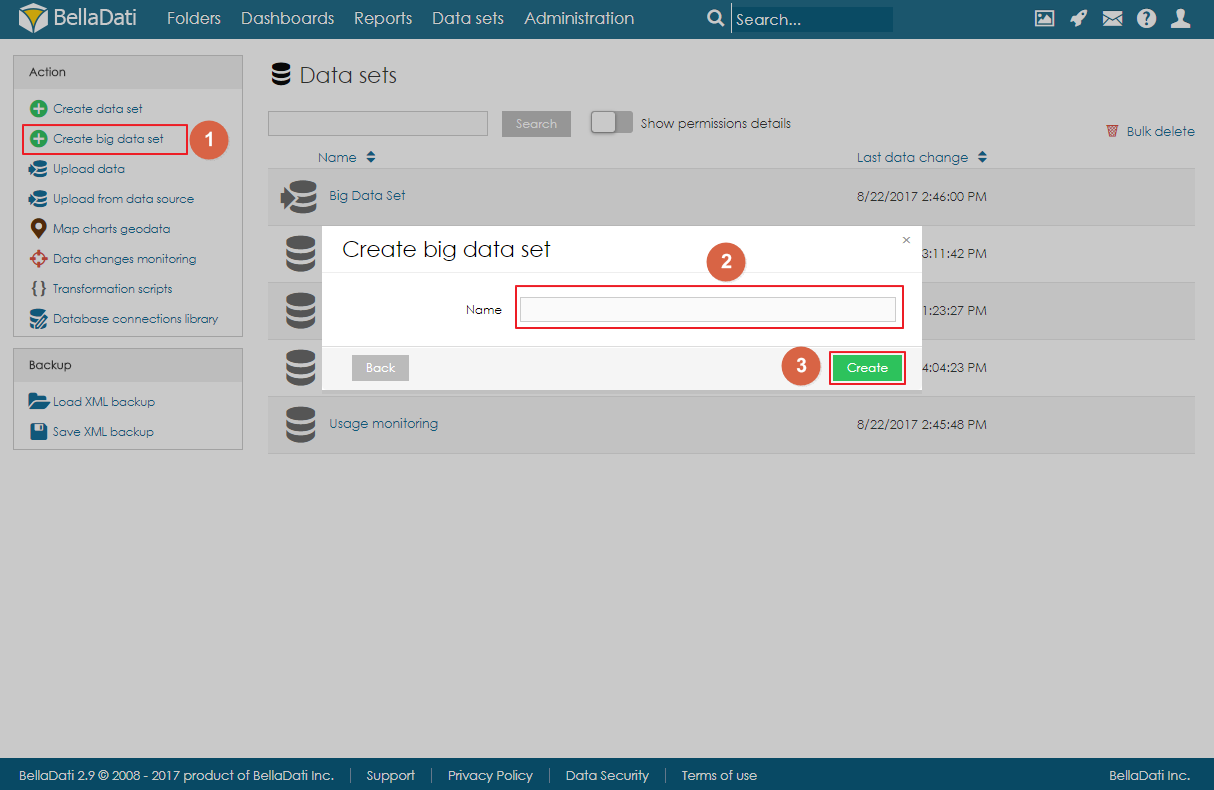

ビッグデータセットの作成

ビッグデータセット機能は、ライセンスとドメインで有効にする必要があることに注意してください。

ビッグデータセットを作成するには、[データセット]ページの[アクション]メニューにある[ビッグデータセットの作成]リンクをクリックし、ビッグデータセットの名前を入力して[作成]をクリックします。

ビッグデータセット サマリーページ

ランディングページ(概要ページ)は、標準のデータセット概要ページに非常に似ています。左側のナビゲーションメニューと、データセットに関する基本情報を含むメインエリアがあります:

- 説明

- 最終更新日

- レコード数

- キューブの概要

- インポートの履歴

アクション

- XMLからの更新 - ユーザーは、カラムが欠落した構造のXMLをアップロードすることができます。これらのカラムは、更新され追加されます。

データのインポート

データは、標準のデータセットと同じ方法で大きなデータをインポートできます。ユーザーは、ファイルまたはデータソースからデータをインポートできます。ただし、ビッグデータセットは標準のインジケータと属性を使用していませんが、代わりに各列がオブジェクトとして定義されています。これらのオブジェクトには、様々なデータタイプがあります:

- テキスト

- 日付

- 時間

- 日付時間

- Geoポイント

- Geo JSON

- ロングテキスト

- ブール値

- 数値

インポート後、ユーザーはデータサンプルページを開いて、データのランダムに選択された部分を表示できます。

オブジェクトの管理

オブジェクト (列) は、インポート中に自動的に作成するか、データモデルページで定義できます。ユーザーは、新しいオブジェクトを追加する際に、名前、データ型、インデックス付け、空の値を含めることができるかどうかを指定できます。 Geoポイント、Geo JSON、ロングテキスト、ブール値、数値はインデックスに登録できないことに注意してください。

行をクリックして、オブジェクトを編集および削除することもできます。

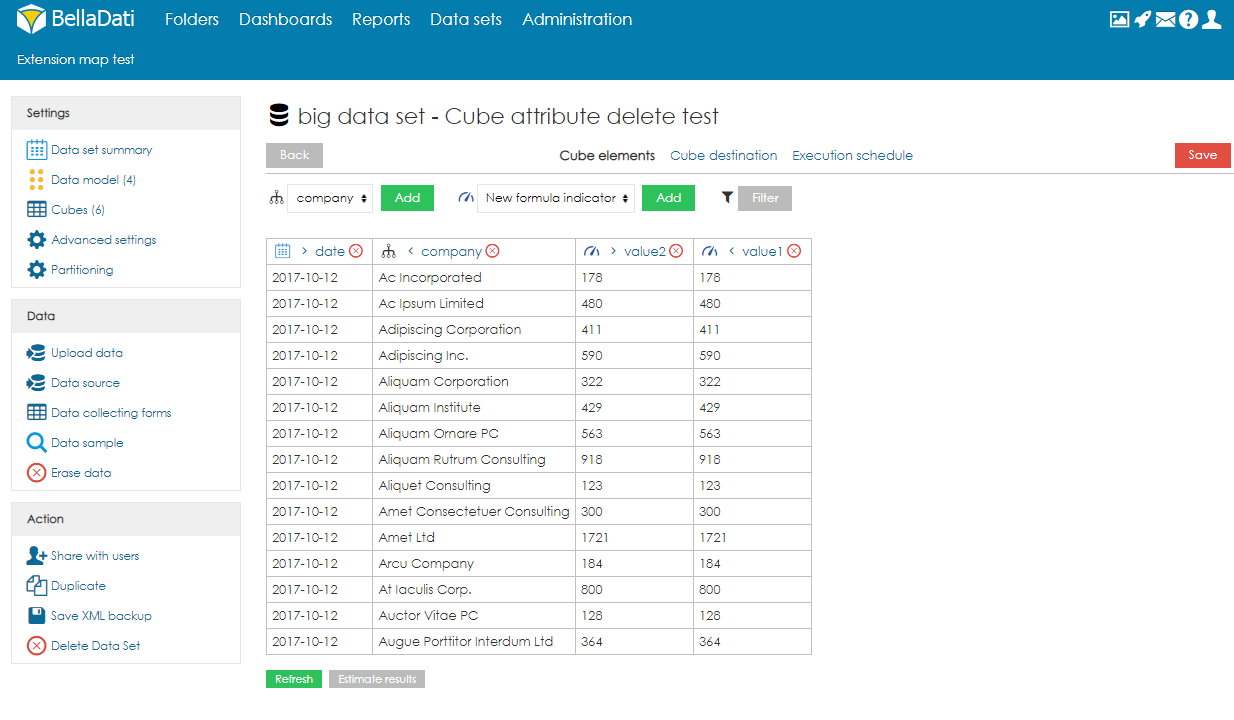

キューブ

キューブは、ビッグデータセットの集計データを含むデータテーブルです。ユーザーは、集計を定義し、フィルターを適用してデータを制限できます。その後、キューブのデータをデータセットにインポートできます。各ビッグデータセットは複数のキューブを持つことができ、各キューブは異なる設定を持つことができます。

キューブの作成

キューブを作成するには、ユーザーは以下の手順に従う必要があります:

- [キューブの作成]をクリックします。

- 名前と、説明(オプション)を入力します。

- 列(属性要素とデータ要素)を選択します。属性要素は、キューブの集約を定義します。例えば、ユーザーが国列を選択すると、データは国ごとに集計されます(1行= 1国)。ユーザーは数式インジケータを作成することもできます。リアルタイムで、ユーザーは画面の右側にキューブのプレビューを表示することもできます。プレビューはデータサンプルのみに基づいて構築されます。つまり、空の場合もありますが、実行後に一部のデータがデータセットにインポートされることに注意してください。Big Data Setの全体のコンテンツの結果を見たい場合は、「Use tablesample」をオフにすることができます。これによりすべてのデータが読み込まれますが、これは負荷がかかる可能性があります。名前の横にある矢印を使用して、属性とインジケータの順序を変更できます。

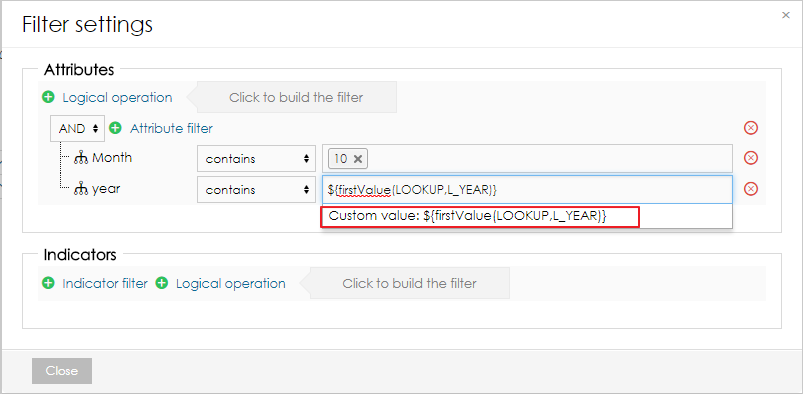

- オプションで、ユーザーはフィルターを適用してデータの一部のみを処理することもできます。

フィルターでは、ユーザーは次の関数を使用して、異なるデータセットの最初と最後の値を参照できます:

${firstValue(DATA_SET_CODE,L_ATTRIBUTE)} ${lastValue(DATA_SET_CODE,L_ATTRIBUTE)} ${firstValue(DATA_SET_CODE,M_INDICATOR)} ${lastValue(DATA_SET_CODE,M_INDICATOR)}この関数は、カスタム値としてフィルターに追加する必要があります。

フィルター式を追加することもできます。これにより、ユーザーはより複雑なフィルターアルゴリズムを作成できます。getLastSuccessfulCubeExecution()関数を使用して、最後に成功したキューブ実行の日付と時刻を取得することもできます。

def f = createFilter() andFilter(f, 'M_TIMESTAMP_INDICATOR', 'GT', timestamp(datetime(getLastSuccessfulCubeExecution().toString('yyyy-MM-dd HH:mm:ss')))) return f

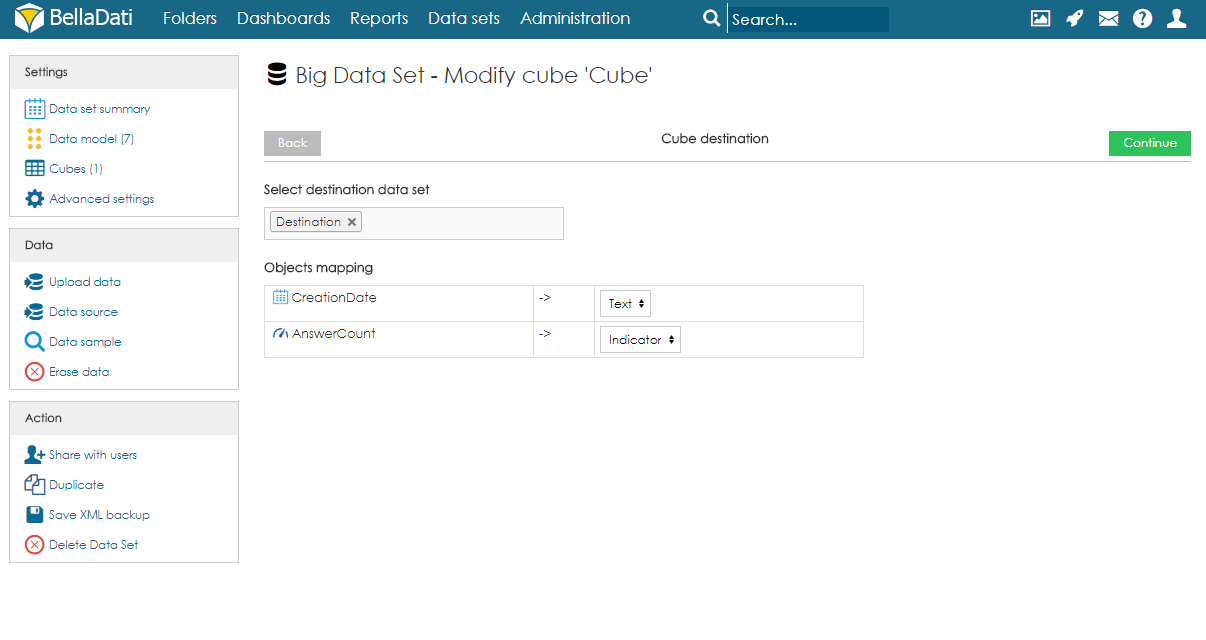

- 宛先データセットとマッピングを選択します。ユーザーは検索フィールドを使用して、宛先データセットを選択する必要があります。実行後、データはキューブからこのデータセットにインポートされます。データセットを選択した後、ユーザーはマッピングを指定する必要があります。キューブの各列は、宛先データセットの属性またはインジケータに割り当てる必要があります。属性要素は、宛先データセットの属性列にマッピングできます。データ要素は、インジケータ列および属性列にマップできます。

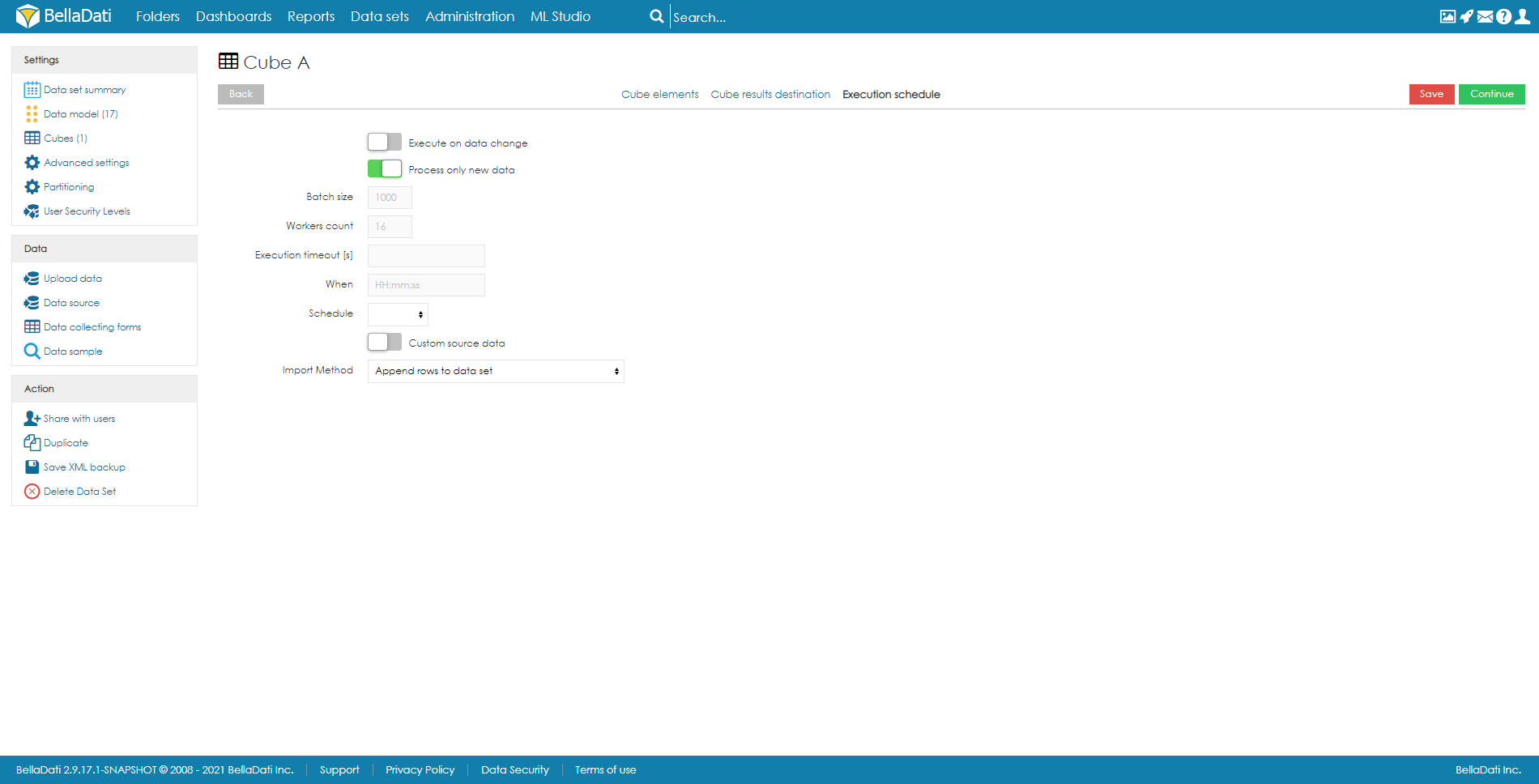

- 実行スケジュールを設定します。実行は手動で、データの変更時、またはスケジュールで実行できます。実行をスケジュールする際、ユーザーは以下のパラメーターを指定できます:

新しいデータのみを処理 - 新しいデータを自動的にフィルタリングするオプション。

バッチサイズ (デフォルトは1,000) - 1つのバッチで実行される行数。特別な場合には、値を増減することが有益な場合があります。ただし、ほとんどの場合、デフォルトのままにしておくことを強くお勧めします。

ワーカーカウント (デフォルトは8) - パラレル実行に使用するワーカーの数。

- 実行タイムアウト [s] - 実行の最大期間を設定します。

いつ - 最初の実行時間。

スケジュール - 実行頻度。

インポート方法 - 宛先データセットのデータで何が起こるべきか。詳細については、データの上書きポリシーをご覧ください。

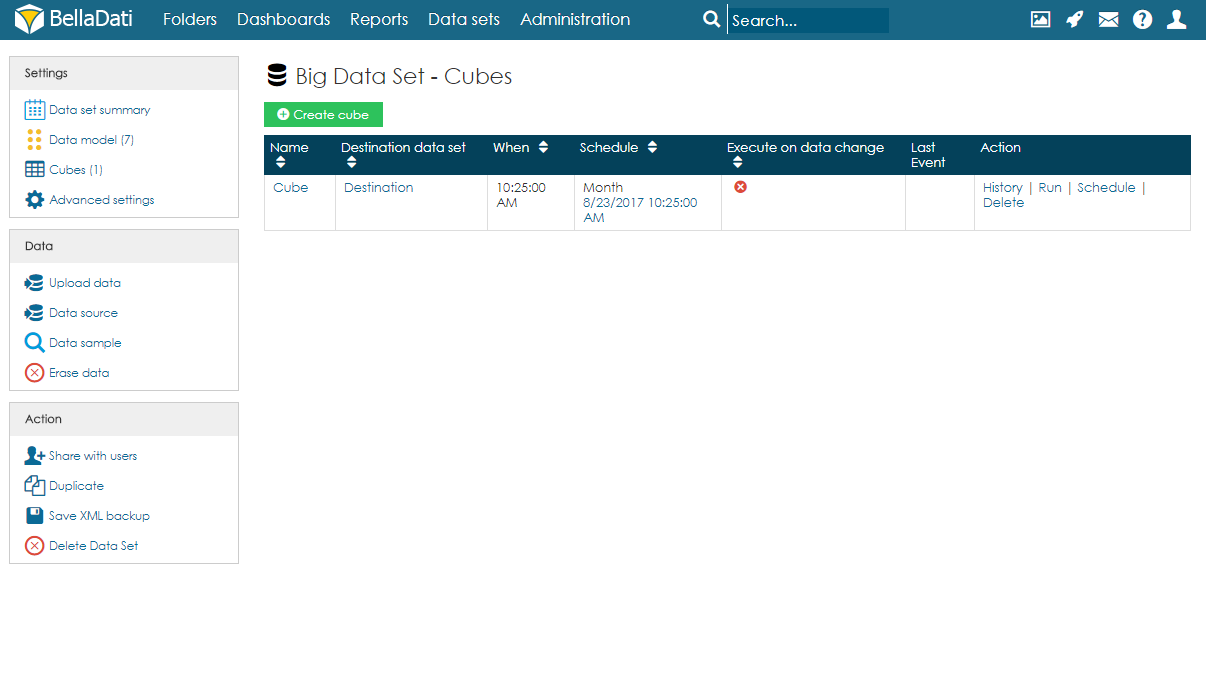

キューブのサマリー

ユーザーは[キューブ]ページで、ビッグデータセットに関連付けられたすべてのキューブを含むテーブルを表示できます。各キューブについて、スケジュールおよび最後のイベントに関する情報が利用可能です。ユーザーは、行またはキューブの名前をクリックすることでキューブを編集することもできます。キューブごとにいくつかのアクションも使用できます:

- 履歴 - 以前の実行とその結果のリストを参照します。

- 実行 - 手動で実行します。

- スケジュール - 実行を再スケジュールします。以前の設定は上書きされます。

- 削除 - キューブを削除します。

キューブの実行

前述のように、実行は手動で、データ変更時に、またはスケジュールによって実行できます。

- 手動実行 - [アクション]列の[実行]をクリックすると、ユーザーは手動で実行を開始できます。また、インポート方法を選択することもできます。インポート方法は、スケジュールによる実行に使用される方法とは異なる場合があります。

- データの変更時 - ビッグデータセットに変更があるたびに、実行が開始されます。既に実行中のキューブの実行がある場合、新しい実行はキューに入れられ、前のキューブの実行が完了した後に自動的にトリガーされます。

- スケジュールによる実行 - 指定された時間が経過した後、定期的に実行されます。

ユーザーは、[スケジュール]列の日付をクリックしてキャンセルを確認することにより、次にスケジュールされている実行をキャンセルすることもできます。これは実行をキャンセルするだけで、削除はしないことに注意してください。手動で実行した後、スケジュールが復元されます。スケジュールされた実行を完全に削除するには、ユーザーはキューブを編集し、実行スケジュールを削除する必要があります。

BellaDati 2.9.18以降、キューブの同時実行の制限が利用可能になりました。

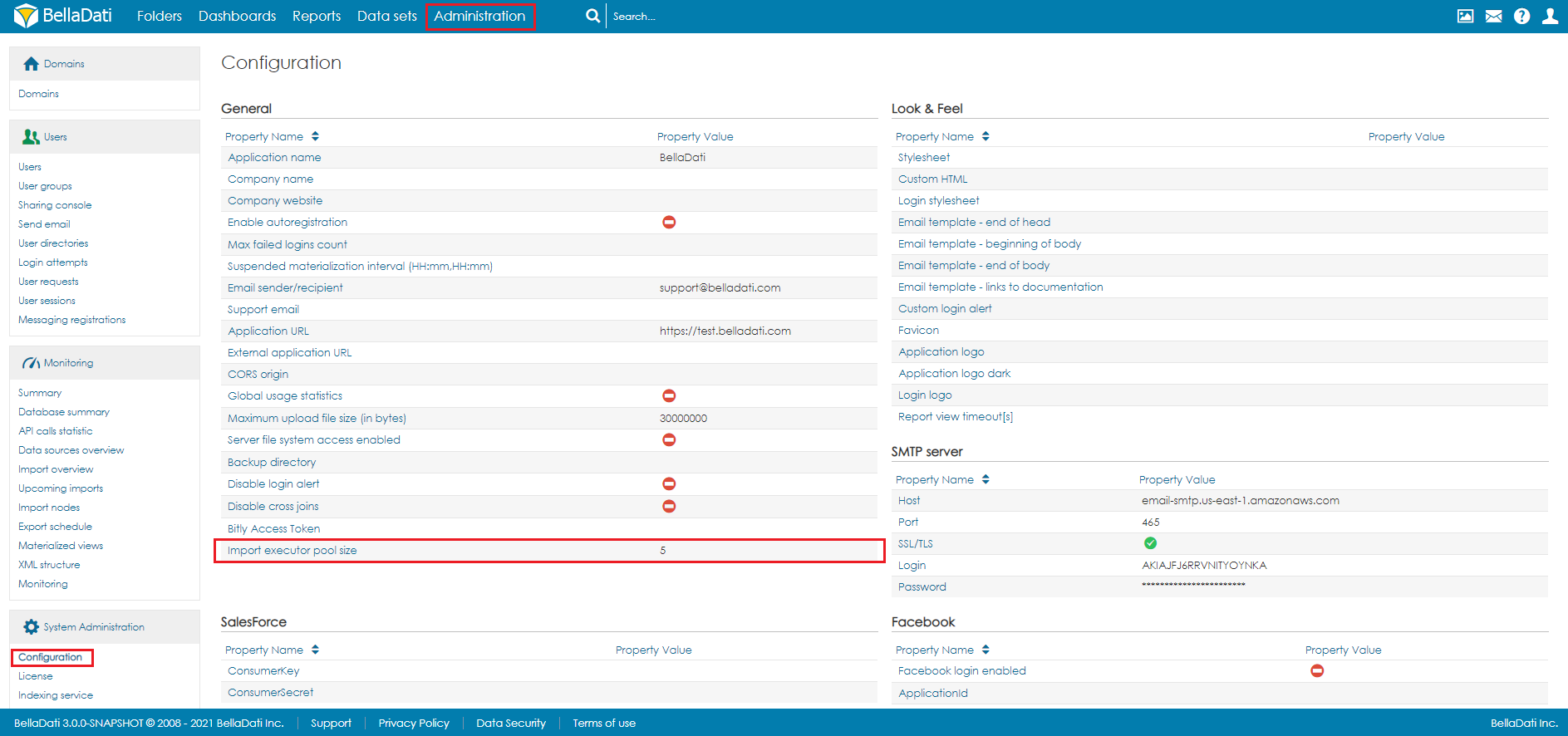

キューブの数が多くなる可能性があるため、同時に実行されるキューブの数には制限があります。デフォルトでは、キューブの同時実行数は5です。変更するには、[管理]から[構成]を開きます。Import executor pool size設定で、制限を定義します。

この設定は、ドメイン管理者の役割を持つユーザーのみが利用可能です。

テーブル

テーブルは、API を使用してビッグ・データ・セットのデータにアクセスするために使用されます。設定は、キューブの設定と同じです。 UID を設定するオプションが追加されています。このオプションにより、対応する行の数が追加され、集計が無効になります。 API を使用してデータを取得する方法については、こちらのドキュメントを参照してください。

ビッグデータセットのバックアップ

ビッグデータセットのXMLバックアップを使用する場合、ターゲットデータセットとキューブ内のマッピングは保存されません。復元後、再度構成する必要があります。